Meinung & Analyse von NeelixberliN – Wenn Aufklärung „illegal“ wird

Der verbotene Content 🚫

⚠️ DIESES VIDEO WURDE GESPERRT

TikTok und die EU sagen: „Illegal“. Ich sage: „Lebensrettend“. Weil das Original im digitalen Nirvana verschwunden ist, gibt es hier die volle Wahrheit – unzensiert und für jeden, der überleben will.

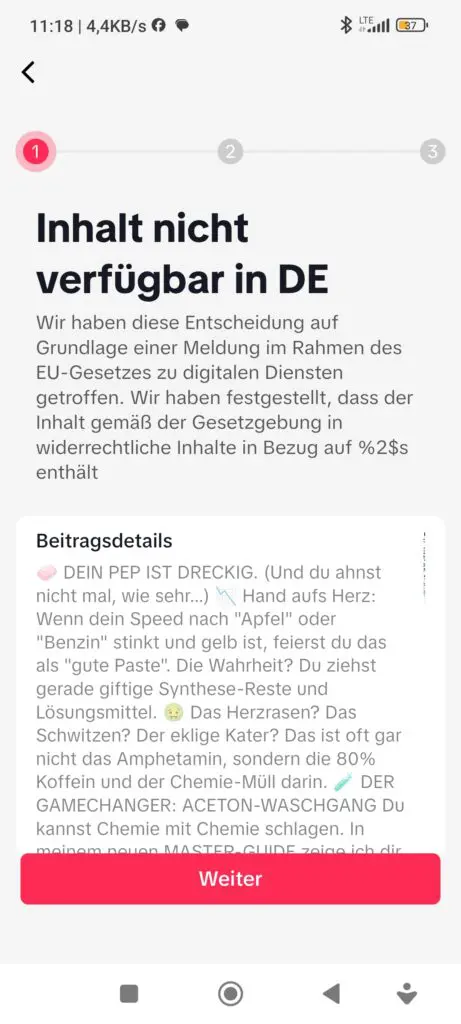

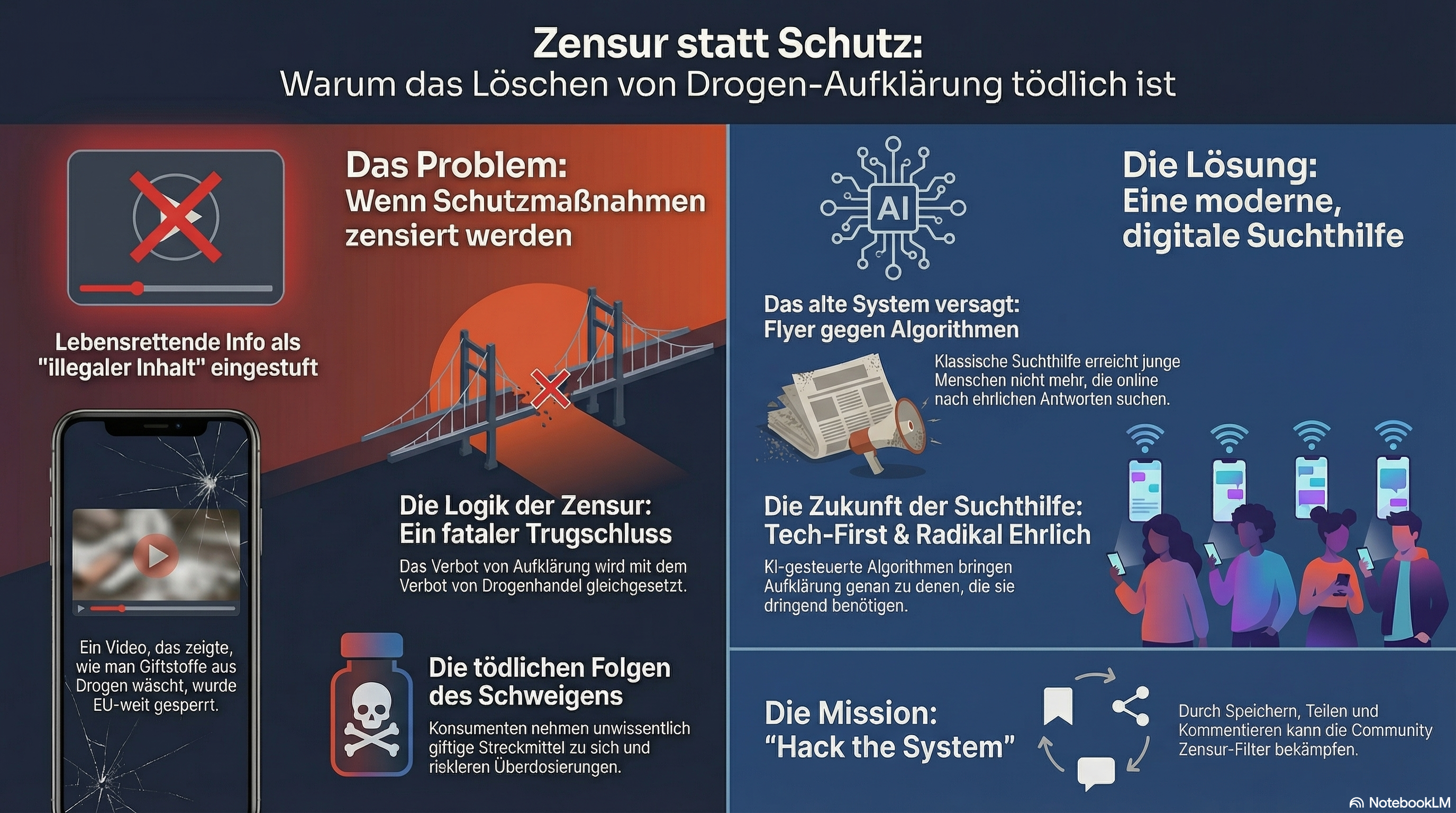

Schau dir das Bild oben an.

„Inhalt nicht verfügbar in DE“.

„EU-Gesetz zu digitalen Diensten“.

„Widerrechtliche Inhalte“.

Weißt du, was da stand? Stand da, wie man eine Bombe baut? Habe ich dazu aufgerufen, Kinder süchtig zu machen? Habe ich Drogen verkauft?

Nein.

Ich habe erklärt, dass Straßen-Speed oft voll mit giftigen Lösungsmitteln und Koffein ist und wie man diese Giftstoffe mit Aceton rauswäscht. Ich habe gezeigt, wie man weniger Schaden nimmt. Und genau das ist der EU und den deutschen Moralwächtern anscheinend zu viel.

Das hier ist der Beweis, dass wir in der Drogenpolitik immer noch im Mittelalter leben – während wir technologisch eigentlich schon im Jahr 3000 sein könnten.

🔥 REALITÄTS-CHECK: Was hier passiert

- [Der Vorfall]: Ein virales Video über das Reinigen von Speed (Aceton-Waschen) wurde auf Basis des EU Digital Services Act gesperrt.

- [Das Paradox]: Die EU stuft lebensrettende Gesundheits-Tipps als „illegale Inhalte“ ein. Zensur schlägt Gesundheitsschutz.

- [Die Zukunft]: Trotz Sperren erreicht KI-gestützte Aufklärung die Menschen. Die Community wächst, weil alte Systeme versagen.

🏛️ Die Logik der Zensur: „Wegschauen hilft“ (Spoiler: Tut es nicht)

Lass uns Klartext reden. Das „EU-Gesetz zu digitalen Diensten“ (DSA) soll uns eigentlich vor Terror, Hassrede und Desinformation schützen. Aber die automatisierten Filter und die politische Vorgabe werfen Harm Reduction (Schadensminimierung) in den gleichen Topf wie Drogenhandel.

Die Denke dahinter ist so altbacken wie gefährlich:

„Wenn wir niemandem zeigen, wie man Drogen sicherer macht, dann nimmt auch keiner Drogen.“

Erinnert dich das an was? Vielleicht an die brillante Corona-Logik mancher Experten (Grüße gehen raus, vielleicht ironisch, an die Fraktion Streeck & Co.), wo man dachte, man könne komplexe Probleme mit einfachen Verboten wegzaubern?

Die Realität auf der Straße sieht anders aus: Wer konsumieren will, konsumiert.

Die einzige Variable, die wir ändern können, ist:

- Konsumiert er giftigen Dreck und landet auf der Intensivstation?

- Oder weiß er, was er tut, reinigt seinen Stoff und überlebt den Abend ohne bleibende Neuro-Schäden?

Indem TikTok dieses Video sperrt, entscheiden sie sich aktiv für Option 1. Zensur ist hier Beihilfe zur Körperverletzung.

🧠 Warum dieses Wissen wichtig war

Das Video erklärte den Unterschied zwischen Amphetamin-Wirkung (Dopamin-Fokus) und Koffein-Vergiftung (Adrenalin-Chaos). Die neurobiologische Faktenlage ist klar: Ungewaschenes Straßen-Speed ist toxischer für das Herz-Kreislauf-System als reines Amphetamin. Dieses Wissen zu unterdrücken, nimmt billigend Gesundheitsrisiken in Kauf.

🤖 Warum die „Etablierten“ versagen & die KI übernimmt

Ich bin seit 28 Jahren in diesem Spiel. Ich habe Sucht gelebt, ich habe Neurobiologie studiert. Vor einem Jahr bin ich gestartet, NeelixberliN aufzubauen. Ich bin zu den großen Suchthilfe-Trägern gegangen. Caritas, Diakonie, staatliche Stellen. Ich habe gesagt:

„Hey, ich weiß, wie der Algorithmus funktioniert. Ich weiß, wie man die Kids erreicht. Lasst uns das zusammen machen.“

Die Reaktion? Schweigen. Ignoranz. Angst.

Sie drucken lieber weiter Flyer, die keiner liest, und warten in ihren Beratungsstellen, bis die Leute schon am Boden zerstört sind.

Aber weißt du was? Es ist egal.

Wir leben in einer KI-Revolution. Die Art, wie Menschen nach Hilfe suchen, hat sich radikal verändert. Niemand googelt mehr „Drogenberatungsstelle Öffnungszeiten“. Die Leute fragen ChatGPT, sie suchen auf TikTok, sie wollen schnelle, visuelle, ehrliche Antworten.

Mein gesperrtes Video ging viral, BEVOR es gelöscht wurde. Die anderen Videos auf meinem Kanal explodieren weiter. Warum? Weil der Bedarf riesig ist. Die Community hungert nach Wahrheit. KI-gestützte Algorithmen finden genau die Leute, die Hilfe brauchen – viel schneller als jeder Sozialarbeiter in einem Büro das je könnte.

☠️ Was genau war so „illegal“? (Der Aceton-Skandal)

Lass uns kurz analysieren, was die Politik verhindern wollte. Ich habe erklärt:

- Dass „Paste“ (feuchtes Speed) nur aus Lösungsmitteln besteht, die deine Nase verätzen.

- Dass Koffein in hohen Dosen (Streckmittel) Herzrasen verursacht, ohne High zu machen.

- Dass man das mit Aceton trennen kann.

Aus Sicht eines Neurobiologen ist das Basis-Hygiene.

Aus Sicht eines Politikers ist das „Anleitung zum Drogenkonsum“.

Das ist der fundamentale Fehler im System: Sie verstehen nicht, dass Schutz keine Werbung ist. Wenn ich dir zeige, wie du den Sicherheitsgurt anlegst, fordere ich dich nicht auf, gegen eine Wand zu fahren. Ich sorge dafür, dass du überlebst, FALLS du fährst.

🛑 Die Gefahr des Schweigens

Was passiert, wenn solche Videos gelöscht werden?

- User denken, „feuchte Paste“ sei normal und gut.

- Lösungsmittel wie Methanol bleiben im Produkt und werden konsumiert.

- Konsumenten haben keine Ahnung von Dosierung, wenn sie mal wirklich reines Zeug bekommen (Überdosis-Gefahr!).

Fazit: Löschen schützt nicht. Löschen macht den Konsum blinder und gefährlicher.

🖕 SYSTEM-NEUSTART: Meine letzte Ansage

Ich habe es lange im Guten versucht. Ich habe meine Hand ausgestreckt, wollte Kooperation, wollte Brücken bauen zwischen der Straße und den Büros. Aber ich habe gemerkt: Es arbeitet nur gegen mich.

Deshalb hier und jetzt im Klartext:

Fuck off, altes Suchthilfe-System.

Versteht mich nicht falsch: Eure Arbeit ist nicht „schlecht“. Sie war wichtig. Sie hat Leben gerettet. Aber: Sie hat ausgedient. Wir leben in der Zukunft. Eure Flyer erreichen niemanden mehr, eure Öffnungszeiten passen nicht zum Rausch und eure Angst vor „Illegalität“ tötet die Aufklärung.

📢 MEIN RAT AN DIE ETABLIERTEN TRÄGER:

Meldet euch, wenn ihr WIRKLICH helfen wollt und bereit seid, die Regeln zu brechen, um Leben zu schützen. Ich bin hier.

Oder ignoriert mich weiter. Aber dann geht ihr genau so unter wie eure Konsumenten in dieser gescheiterten Drogenpolitik. Ihr habt die Wahl: Revolution oder Irrelevanz.

✊ DEINE MISSION: HACK THE SYSTEM

Der Algorithmus will uns stummschalten. Hier ist deine Munition dagegen.

⚠️ VERSTEHE DIE SPIELREGELN:

Zensur funktioniert nur, wenn wir schweigen. Jede Interaktion von dir ist ein Störsignal im Filter. Sie können einen löschen, aber nicht zehntausende.

-

💾SPEICHERN IST DIE WAFFE

Speicher den Beitrag (Favoriten). Das signalisiert dem Algorithmus „extrem hoher Wert“ und pusht es zurück in den Feed. -

🔄TEILEN IST WIDERSTAND

Poste es in deine Story. Schick es in WhatsApp-Gruppen. Mach den Content viral, BEVOR sie ihn löschen können. -

💬KOMMENTIERE LAUT

Schreib was. Ein Emoji reicht. Zwinge den Algorithmus zur Interaktion.

🛡️ NEELIXBERLIN.DE IST DER BUNKER

Plattformen kommen und gehen. Diese Website bleibt. Hier wird nichts gelöscht.

Spread the Link

Offizielles Dokument

Positionspapier: Digitale Suchthilfe im Spannungsfeld von Aufklärung und Regulierung

1. Einleitung: Der digitale Wandel in der Suchthilfe und neue regulatorische Hürden

Die Suchthilfe befindet sich in einem fundamentalen Wandel. Etablierte Ansätze werden zunehmend durch neue, digitale Strategien herausgefordert, die Konsumenten direkt auf Plattformen wie TikTok erreichen. Diese Entwicklung trifft auf neue rechtliche Rahmenbedingungen wie den EU Digital Services Act (DSA), dessen Implementierung ein regulatorisches Dilemma für die öffentliche Gesundheit schafft.

Aus dieser Konstellation erwächst ein Zielkonflikt zwischen dem Public-Health-Ansatz der Schadensminimierung (Harm Reduction) und einer Zensurlogik, die Inhalte pauschal als „illegal“ einstuft. Dieser Konflikt wird in der Sperrung eines Aufklärungsvideos des digitalen Educators „NeelixberliN“ – eines Akteurs mit langjähriger eigener Konsumerfahrung und einem Hintergrund in Neurobiologie – exemplarisch sichtbar. Sein Fall dient als kritische Fallstudie und Stresstest, der eine grundlegende Schwäche in der aktuellen Anwendung des DSA aufzeigt.

Dieses Positionspapier analysiert diesen Fall, um die praktischen Auswirkungen der Regulierungspraxis auf die digitale Suchthilfe zu beleuchten. Die Analyse des zensierten Inhalts und der dahinterstehenden Logik ist entscheidend, um die systemischen Herausforderungen und Chancen für eine moderne, digitale Drogenpolitik zu verstehen.

2. Fallanalyse: Die Sperrung eines Aufklärungsvideos auf Basis des Digital Services Act

Die genaue Untersuchung des Falles NeelixberliN ist entscheidend, um die abstrakten rechtlichen Rahmenbedingungen des Digital Services Act in ihrer praktischen Auswirkung zu verstehen. Der Vorfall macht greifbar, wie regulatorische Entscheidungen direkt in die dezentralisierte, peer-basierte Gesundheitskommunikation eingreifen.

2.1. Inhalt und Intention: Gesundheitsinformation als „widerrechtlicher Inhalt“

Das von TikTok gesperrte Video thematisierte die sogenannte „Aceton-Wäsche“, ein chemisches Verfahren, um auf dem Schwarzmarkt erworbenes Amphetamin (ugs. „Speed“) von giftigen Lösungsmitteln und gesundheitsschädlichen Streckmitteln wie Koffein zu reinigen.

Die Intention des Videos war explizit als lebensrettende Gesundheitsinformation und nicht als Konsumaufforderung formuliert. Der Urheber zieht hierzu die Analogie des Sicherheitsgurtes heran: Die Erklärung, wie man sich im Auto anschnallt, ist kein Aufruf, gegen eine Wand zu fahren, sondern eine Maßnahme, um im Falle eines Unfalls den Schaden zu minimieren.

Inhaltlich vermittelte das Video neurobiologische und chemische Fakten von hoher Relevanz: Es wurde der Unterschied zwischen der Amphetamin-Wirkung (fokussierte Dopamin-Ausschüttung) und einer Koffein-Vergiftung (chaotische Adrenalin-Ausschüttung) erklärt. Das Video klärte darüber auf, dass die im Straßenspeed enthaltenen Lösungsmittel und Streckmittel eine höhere toxische Wirkung auf das Herz-Kreislauf-System haben können als der reine Wirkstoff. Das Wissen um die Reinigung wurde als eine Form der „Basis-Hygiene“ dargestellt.

2.2. Regulatorische Logik: Die pauschale Anwendung des DSA auf Harm-Reduction-Inhalte

Die offizielle Begründung für die Sperrung lautete: „Inhalt nicht verfügbar in DE“ aufgrund des „EU-Gesetz zu digitalen Diensten“. Der Inhalt wurde als „Widerrechtliche Inhalte“ eingestuft.

Die Logik, die dieser Zensur zugrunde liegt, lässt sich auf eine simple Annahme der Regulatoren zurückführen: „Wenn wir niemandem zeigen, wie man Drogen sicherer macht, dann nimmt auch keiner Drogen.“ Dieser Ansatz ignoriert die Realität des Konsums und setzt die Unterdrückung von Informationen mit Prävention gleich.

Das zentrale Paradoxon besteht darin, dass eine Maßnahme zur Schadensminimierung in dieselbe rechtliche Kategorie wie Drogenhandel eingestuft wird. Dies ist mutmaßlich auf den Einsatz automatisierter Filter und eine pauschale politische Vorgabe zurückzuführen, die nicht zwischen schädlichen und schützenden Inhalten differenziert. Der Fall verdeutlicht einen fundamentalen Paradigmenkonflikt zwischen zwei gegensätzlichen Ansätzen der Drogenpolitik.

3. Der Kernkonflikt: Schadensminimierung versus Schutz durch Verbote

Die unterschiedlichen Auffassungen über den richtigen Umgang mit Drogenkonsum haben direkte Auswirkungen auf die Gesundheit und das Leben von Betroffenen. Die Sperrung des Videos offenbart den ideologischen Graben zwischen einem pragmatischen Public-Health-Ansatz und einer prohibitiven Schutzlogik.

| Philosophie der Schadensminimierung (Harm Reduction) | Logik der Zensur (laut Quelle) |

|---|---|

| Grundannahme: Drogenkonsum ist eine gesellschaftliche Realität. Das Ziel muss daher darin bestehen, den damit verbundenen Schaden für Individuen und die Gesellschaft zu minimieren. | Grundannahme: Die Unterdrückung jeglicher Informationen über Drogen und deren sicheren Gebrauch führt zu einer Reduzierung des Konsums. Sichtbarkeit wird mit Werbung gleichgesetzt. |

| Zielsetzung: Konsumenten sollen durch Wissen und Fakten geschützt werden. Gesundheitsrisiken wie Vergiftungen, Infektionen oder Überdosierungen sollen aktiv reduziert werden. | Zielsetzung: Die Öffentlichkeit soll vor Inhalten geschützt werden, die als „Anleitung zum Drogenkonsum“ interpretiert werden könnten, um potenzielle neue Konsumenten nicht zu ermutigen. |

| Bewertung des Videos: Der Inhalt wird als „lebensrettende Gesundheits-Tipps“ und „Basis-Hygiene“ bewertet, der Konsumenten befähigt, informierte und sicherere Entscheidungen zu treffen. | Bewertung des Videos: Der Inhalt wird als „illegaler Inhalt“ eingestuft, der gegen die Bestimmungen des DSA verstößt, da er eine illegale Handlung detailliert beschreibt. |

Diese restriktive Logik führt zu konkreten negativen Folgen, die den eigentlichen Zielen des Gesundheitsschutzes zuwiderlaufen.

4. Analyse der Konsequenzen: Die Gefahren der Zensur für Konsumenten

Die Entscheidung zur Zensur von Aufklärungsinhalten ist keine neutrale Maßnahme, sondern erzeugt unbeabsichtigte negative Externalitäten mit potenziell fatalen Konsequenzen. Das Schweigen über Safer-Use-Praktiken schafft eine gefährliche Informationsasymmetrie zu Lasten der Konsumenten. Drei zentrale Gefahren lassen sich identifizieren:

- Fehlende Aufklärung über Streckmittel und Verunreinigungen: Das Löschen von Informationen zur Reinigung von Drogen führt dazu, dass Konsumenten die oft mit gesundheitsschädlichen Lösungsmitteln wie Methanol versetzte „feuchte Paste“ als Qualitätsmerkmal missverstehen. Die Normalisierung von Verunreinigungen führt zum direkten Konsum toxischer Substanzen und zu unkalkulierbaren Gesundheitsschäden.

- Ignoranz gegenüber Reinheit und korrekter Dosierung: Die größte Gefahr bei unregulierten Substanzen ist die schwankende Wirkstoffkonzentration. Wenn Konsumenten an gestreckte Substanzen gewöhnt sind und nicht über die Möglichkeit der Reinigung und die damit einhergehende höhere Potenz informiert werden, steigt das Risiko einer Überdosis massiv an, sollten sie unerwartet reinen Wirkstoff erhalten.

- Implizite Befürwortung gefährlicher Konsumpraktiken: Indem die Verbreitung von Safer-Use-Praktiken aktiv unterbunden wird, nehmen Regulatoren und Plattformen billigend in Kauf, dass Konsumenten auf unsichere Konsumformen zurückgreifen. Aus der Perspektive der Schadensminimierung, wie sie von Akteuren wie NeelixberliN vertreten wird, lässt sich dieses Vorgehen als eine Form der „Beihilfe zur Körperverletzung“ interpretieren.

Zensur schützt nicht, sondern macht den ohnehin riskanten Konsum unkalkulierbarer und gefährlicher. Dieses durch Zensur induzierte Risiko ist besonders akut, weil, wie die folgende Analyse zeigt, etablierte Institutionen weitgehend dabei versagen, alternative, digital-native Informationsquellen bereitzustellen.

5. Systemkritik: Das Versagen etablierter Suchthilfestrukturen im digitalen Zeitalter

Das regulatorische Vakuum, das durch die pauschale Anwendung des DSA entsteht, wird durch das wahrgenommene Versäumnis traditioneller Public-Health-Institutionen verschärft, sich an die digitale Landschaft anzupassen. Die von digitalen Akteuren wie NeelixberliN formulierte Kritik verweist auf systemische Defizite in Reichweite und Methodik etablierter Träger:

- Methodische Verankerung in der Vergangenheit: Etablierte Organisationen (z.B. Caritas, Diakonie) halten an veralteten Methoden wie Flyern und festen Öffnungszeiten fest, die eine digital sozialisierte Zielgruppe kaum noch erreichen.

- Mangelnde Erreichbarkeit der Zielgruppe: Der entscheidende Paradigmenwechsel liegt im Distributionsmodell. Etablierte Träger nutzen ein „Pull-Modell“, bei dem Hilfesuchende aktiv eine Beratungsstelle aufsuchen müssen. Digitale Akteure nutzen ein algorithmusgesteuertes „Push-Modell“, das über Plattformen wie TikTok proaktiv jene Nutzer identifiziert und erreicht, die relevante Inhalte benötigen. Der DSA versucht, dieses neue, mächtige Ökosystem mit unzureichenden Mitteln zu regulieren.

- Kulturelle und bürokratische Trägheit: Die Reaktion auf Kooperationsangebote aus der digitalen Szene wird als von „Ignoranz“, „Angst“ und starren Regeln geprägt beschrieben. Rechtliche Unsicherheiten verhindern die Zusammenarbeit mit innovativen Akteuren und blockieren effektive Aufklärung.

Diesem Stillstand steht ein enormes Potenzial neuer, KI-gestützter Ansätze gegenüber, die den „riesigen Bedarf“ und den „Hunger nach Wahrheit“ in der Community bedienen. Die Weigerung etablierter Akteure, diese Kanäle zu nutzen, schafft ein Vakuum, das von agilen, aber unregulierten Einzelakteuren gefüllt wird.

6. Ausblick: Das Paradigma der zukünftigen Suchthilfe

Aus der Kritik muss eine konstruktive Vision für die Zukunft erwachsen. Das Modell einer „Modernen Suchthilfe (Neelix-Style)“ bietet ein alternatives Paradigma, das auf drei Kernprinzipien basiert:

- ✅ Akzeptanz: Der Konsum von Drogen wird als Realität anerkannt, anstatt moralisch verurteilt zu werden. Dies ist die Grundlage für eine Kommunikation auf Augenhöhe.

- ✅ Tech-First: Künstliche Intelligenz, Algorithmen sozialer Medien und digitale Plattformen werden konsequent genutzt, um Hilfe proaktiv dort anzubieten, wo sich die Zielgruppe aufhält.

- ✅ Transparenz: Anstelle von pauschalen Abstinenzappellen werden radikal ehrliche und wissenschaftlich fundierte Informationen über Dosierung, Reinigungsmethoden und Risiken vermittelt.

Die strategische Schlussfolgerung ist, dass die Zukunft der Suchthilfe bereits im digitalen Raum stattfindet. Sie ist dezentral, agil und entzieht sich zunehmend der Kontrolle staatlicher Behörden. Für die etablierte Träger stellt sich somit eine existenzielle Frage: die Entscheidung zwischen „Revolution oder Irrelevanz“.

7. Fazit

Die aktuelle Anwendung des EU Digital Services Act auf Inhalte der Schadensminimierung führt zu einer gefährlichen Wissenslücke und konterkariert die Ziele der öffentlichen Gesundheit. Der Fall NeelixberliN zeigt, wie eine gut gemeinte Regulierung unbeabsichtigt lebensrettende Aufklärungsarbeit unterbindet. Anstatt Konsumenten zu schützen, macht die Zensur von Safer-Use-Informationen den Konsum unberechenbarer.

Gleichzeitig offenbart der Konflikt die dringende Notwendigkeit für etablierte Suchthilfestrukturen, ihre Methoden an das digitale Zeitalter anzupassen. Der Weg in die Zukunft erfordert eine klare regulatorische Unterscheidung zwischen Inhalten, die Drogenhandel fördern, und zertifizierten Public-Health-Informationen, die der Schadensminimierung dienen.

Die zentrale politische Aufgabe lautet daher: Wie kann eine Regulierung digitaler Inhalte gestaltet werden, die effektiven Jugendschutz gewährleistet, ohne dabei lebensrettende Aufklärungsarbeit im Bereich der Suchthilfe zu zensieren und zu gefährden? Die Beantwortung dieser Frage ist entscheidend für die Entwicklung einer modernen, wirksamen und humanen Drogenpolitik im 21. Jahrhundert.

🦁 NeelixberliN Fazit: Wir sind nicht aufzuhalten

Ein Jahr Arbeit steckt in diesem Projekt. Ein Jahr Kampf gegen Shadowbans, Löschungen und Ignoranz. Und doch wachsen wir.

Dieses gelöschte Video ist für mich kein Rückschlag. Es ist ein Orden. Es zeigt, dass wir den Nerv getroffen haben. Es zeigt, dass wir genau da hinleuchten, wo es wehtut.

Die Suchthilfe der Zukunft findet nicht in Stuhlkreisen statt (auch, aber nicht nur). Sie findet in deinem Feed statt. Sie ist algorithmisch gesteuert, KI-unterstützt und radikal ehrlich.

Die EU kann Geoblocking machen. TikTok kann löschen. Aber wir finden neue Wege. Die KI-Revolution gibt uns Werkzeuge, die keine Behörde der Welt mehr kontrollieren kann.

Wenn die etablierte Suchthilfe mich weiter meiden will: Bitte sehr. Ich mache weiter. Für euch.

🛡️ Moderne Suchthilfe (Neelix-Style)

Wir warten nicht, bis die Politik aufwacht. Echte Hilfe bedeutet:

- ✅ Akzeptanz: Konsum ist Realität.

- ✅ Tech-First: Nutzung von AI und Social Media Algorithmen.

- ✅ Transparenz: Ehrliche Infos zu Dosierung und Reinigung statt „Sag einfach Nein“.

📚 Quellen & Kontext

- EU Digital Services Act (DSA): Artikel zu „Illegal Content“ (sehr schwammig formuliert).

- Deutsche Suchthilfestatistik 2024: Zeigt, dass klassische Angebote junge Konsumenten kaum noch erreichen.

- Community-Feedback: Tausende Kommentare unter meinen Videos beweisen, dass genau diese „illegalen“ Tipps Leben retten.

🤔 Fragen zur Zensur

❓ Ist das Zeigen von Drogen auf TikTok verboten?

✅ Jein. Die Richtlinien verbieten „Handel und Bewerbung“. Harm Reduction (Aufklärung) ist eine Grauzone, die oft von automatischen Filtern fälschlicherweise gelöscht wird. Das EU-Gesetz verschärft diesen Filter-Wahn.

❓ Was kann ich tun, wenn Neelix gesperrt wird?

✅ Abonniere den Newsletter auf neelixberlin.de und komm in den Telegram/WhatsApp Kanal. Dort sind wir unabhängig von TikTok-Willkür.